El marketing online tiene una gran ventaja sobre el tradicional ya que cada impacto y cada venta se puede llegar a medir con un nivel de precisión asombroso.

Pero que las herramientas sean fácilmente configurables y enseguida veamos datos sobre nuestra pantalla no quiere decir que sean ciertos.

En este post voy a hablar de cómo un dato puede ser verdad y mentira al mismo tiempo. Da igual que seas SEO, Community, Analista, de PPC… esto te interesa.

Entérate del próximo lanzamiento del Curso de CRO desde Cero

👉 Curso disponible solo para suscriptores.

¿Qué es la Paradoja de Simpson?

A lo mejor has oido hablar de ella como el efecto Yule Simpson.

Es una paradoja en la cual una tendencia que aparece en los datos desaparece cuando estos se combinan y en su lugar aparece la tendencia contraria.

Puedes consultar la definición completa y algunos ejemplos reales de este efecto en la wikipedia.

Esto significa que analizando nuestro proyecto con cualquiera de nuestras herramientas (Google Analytics, Google Ads, Search Console…) podríamos llegar a conclusiones opuestas con los mismos datos.

¿Por qué es importante entenderla?

Evidentemente, una mala lectura de los datos nos va a llevar a tomar malas decisiones.

Veámoslo con un ejemplo en un test A/B sobre una landing.

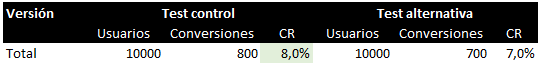

Realizamos un experimento en una web donde testamos dos versiones, derivando el 50% del tráfico a cada página.

Mantenemos sin cambios la versión original de una página, que llamaremos Test Control y creamos una landing nueva con un diseño diferente que llamaremos Test Alternativa.

Tras finalizar el experimento, y suponiendo que tiene validez estadísitica, tenemos estos resultados:

Vemos que la versión de control ha convertido más que la versión alternativa, por lo que tomamos la decisión de mantener el diseño de la página tal y como está.

¿Seguramente haríamos eso cualquiera de nosotros, verdad?

Pero si …

Contenido dispoinible en el curso de CRO

Vemos que realmente los datos de conversión por dispositivo son mejores en la versión nueva. Por lo que resulta que es la landing alternativa la que deberíamos implementar.

Conclusión

Independientemente de que estés analizando una campaña de PPC, de Facebook Ads, un test A/B o el rendimiento de keywords en Search Console, no te precipites a la hora de sacar conclusiones.

Bucea en los datos y segmenta todo lo que puedas.

A nivel personal, mejor no hacer mucho caso de los datos que escuchamos, vemos y leemos a diario en los medios.

- A/B Testing (1)

- Analítica digital (3)

- Copywriting (1)

- CRO (8)

- Newsletter (47)

- Tráfico (3)

- UX (1)

- WPO (1)

Muchas gracias, Rodrigo. Con la aclaración me queda más claro! 🙂

Hola Miguel, gracias por comentar.

Efectivamente si controlas de antemano la muestra para que sea análoga, no solo en categoría de dispositivos sino también en otros factores importantes como canal de adquisición, resolución de pantalla, tipo de navegador, país… el resultado no varía. El problema es que no siempre es posible poder realizar un test con una muestra grande y equitativa de todas estas variables que influyen (o pueden influir) en los resultados, es ahí donde se hace necesario segmentar y asegurarse de que tomamos la decisión correcta a la hora de dar por ganador una variación u otra.

Me he quedado un rato pensando y no lo podía creer… al final he visto que el tráfico se invierte entre mobile/desktop en la web alternativa. Me gusta la ilustración pero esto es algo poco frecuente con una muestra relativamente grande, no? En el test AB, para poder aislar efectos, la muestra deberia ser análoga entre las variantes, no?